מהפכת המידע

בכל חודש יש כ-1.25 מיליארד משתמשי פייסבוק פעילים וכמיליארד צופים ב-6 מיליארד שעות ביוטיוב. כל שנייה יש 70 אלף חיפושים בגוגל ו-9,000 ציוצים בטוויטר. איך משתלטים על כל המידע הזה? הכל על ביג דאטה

18 בספטמבר 2013. מפרץ סן פרנסיסקו. השעון הראה שתיים ורבע בצהריים ושאגות השמחה של הצוות הניו זילנדי, על יאכטת הקטמרן במימי המפרץ, נשמעו עד החוף. הניו זילנדים גברו זה עתה על הצוות האמריקאי ((Oracle Team USA בשיוט נוסף כחלק מהתחרות America's Cup, מהתחרויות הוותיקות בהיסטוריה של הספורט בכלל, וכנראה היוקרתית ביותר בשיט היאכטות. לוח התוצאות הראה 8-1, תבוסה חסרת פשרות של האמריקאים לניו זילנדים, מלכי הים. לניו זילנדים חסַר עוד ניצחון אחד לזכייה בתחרות כולה. אף אחד לא דמיין לעצמו שהתחרות רק החלה ושהאמריקאים נמצאים לפני הקאמבק הגדול בהיסטוריה של השיט, לפני ניצחון דרמטי 8-9.

אז איך באמת קרה מהפך כזה? ומדוע בכלל אנחנו מספרים לכם את הסיפור הזה, פה במגזין מדע? ובכן, העובדה נעוצה ביאכטה עצמה, ה־AC72, שנבנתה במיוחד לתחרות זו. היאכטה נבנתה בזכות 100 מיליון דולר (!) שהשקיע בבנייתה לארי אליסון, מנכ"ל ומייסד חברת ההיי־טק האגדית אורקל. על פי פוסט שפרסם אסים קאן, דירקטור מערכות המידע של צוות השיט של אורקל (כן, יש להם דבר כזה) מיד בתום התחרות, יותר מ־300 חיישנים על פני היאכטה הזרימו 200 ג'יגה בייט של מידע בזמן אמת, בכל יום שיוט, לשרתים שבגוף היאכטה, ששם עובדו הנתונים בזמן אמת ושלטו בצורה אוטומטית בכל הפרמטרים של היגוי היאכטה – למשל בכיוון השיוט, במִפתח המפרשים ובזווית השיוט שלה מעל פני המים.

סיפור זה ממחיש בצורה הטובה ביותר את השימוש ב"ביג דאטה" (Big Data): שימוש בכמות עצומה של מידע, איסופו ממקורות שונים, בפורמטים שונים ובאיכויות שונות, אחסונו, עיבודו, מציאת קשרים, תבניות והסקת תובנות מתוכו, ולבסוף, שימוש בתובנות אלו בצורה אופרטיבית, או במקרה הזה, שליטה אוטומטית בהיגוי היאכטה.

אז איך בכל זאת, עם כל הטכנולוגיה הזאת, פיגר הצוות האמריקאי בתחילת התחרות והיה רחוק כדי יום אחד בלבד מתבוסה? לכך שתי סיבות: האחת קשורה למקצוע השיט והיא רלוונטית פחות לכתבה זו. הסיבה השנייה נעוצה במדעי הנתונים (Data Science). היאכטה, כמערכת שלומדת עם הזמן (Machine Learning), עשתה שימוש בביג דאטה בשיוטים הראשונים ולמדה בזמן אמת, ככל שהתקדמה התחרות, את הערכים האופטימליים לפרמטרים של היגוי היאכטה, בהתאם לתנאים בזמן אמת. תוצאות החיזוי הלכו והפכו מדויקים יותר ככל שהתקדמה התחרות, ולבסוף הכריעו את הכף.

המונח ביג דאטה נחשב לאחד המושגים הטכנולוגיים החמים ביותר כיום, והוא כלל לא היה בשימוש עד לפני שנתיים. ה"הייפ" סביבו גדול כל כך, והבלבול אודותיו גדול הרבה יותר. אך הכצעקתה? האם מדובר בבועה או בטכנולוגיה אמיתית שמעצבת מחדש את עולמנו? או כמו שאמר פרופ' דן אריאלי: "ביג דאטה הוא כמו סקס בין בני נוער. כולם מדברים על זה, כולם חושבים שכל השאר עושים את זה, כך שכולם טוענים שהם עושים את זה".

כתבה זו מבקשת לסדר ולפרט על הטכנולוגיה, על מרכיביה ועל השימושים בה, כך שגם אם אינכם עושים בה שימוש, תדעו לפחות על מה כולם מדברים.

מה זה ביג דאטה?

לטכנולוגיית ביג דאטה יש שני פנים: התשתית, שכינויו בפשטות ביג דאטה (Big Data), והיא מיועדת לאחסון ולעיבוד כמויות נתונים אדירות, כמו בסיפור שתיארנו; ומדעי הנתונים (Data Science), המוכר לפעמים בשמות אחרים, כמו מערכות לומדות (Machine Learning), כריית מידע (Data Mining), אנליזת נתונים ((Data Analysis וחיזוי אנליטי (Predictive Analytics) שכולם מתארים פחות או יותר את אותה הפעולה – שימוש בכמויות מידע עצומות כדי להסיק מתוכן, בצורה אוטומטית, תובנות בעלות ערך.

ביג דאטה היא תופעת לוואי טכנולוגית של תופעה חברתית רחבה הרבה יותר, שהעולם כולו שותף לה כעת – מהפכת המידע. למהפכות ששינו את פני האנושות יש תבנית משותפת: כולן התחילו בהמצאה טכנולוגית שהובילה למהפכה חברתית. כך היה למשל עם המצאת הדפוס של גוטנברג במאה ה־15, המצאה שהובילה לבסוף לפיחות במעמדה של הכנסייה הקתולית. כך היה גם עם המצאת מנוע הקיטור במאה ה־18, המצאה שהובילה למהפכה התעשייתית, יצרה את מעמד הפועלים והביאה בסופו של דבר לקץ הפאודליזם באירופה. מהפכת המידע החלה עם המצאת האינטרנט, שהגדיר מדיום תקשורת חדש, תקשורת מגה המונים, שמחברת פוטנציאלית את כל תושבי העולם בינם לבין עצמם, באופן מיידי. האפקט הזה, הידוע בכינויו אינטרנט 2.0, שהמשתמשים עצמם הם אלו שמייצרים את התוכן בענן האינטרנט, הביא לשיטפון מידע ונתונים, והוא מה שמכונה כיום "ביג דאטה".

בעולם שבו מידע הוא כוח, הרבה מידע הוא הרבה כוח. איך הופכים את המידע הרב הזה (ביג דאטה) להרבה כוח? ואיך באמת המידע הרב הזה מתורגם הלכה למעשה, בצורה אופרטיבית, לדבר מה בעל ערך ממשי? בעולם של היום, שבו התחרות העסקית כה גבוהה והשינויים כה מהירים, יצירת יתרון עסקי לפני המתחרה שלך, היא שם המשחק. האינטרנט (הסלולרי במיוחד) כמדיום מגה המוני, כאמור, יצר הלכה למעשה ערוץ תקשורת פוטנציאלי עם כל אדם המחובר לרשת, על פני כל מקום על כדור הארץ ובאופן מיידי. זהו בעצם הגביע הקדוש של העסקים, שכן ההזדמנויות העסקיות שנוצרות כיום הן חסרות תקדים. דוגמה לכך היא שכיום עסקים יכולים לפלח את בסיס הלקוחות שלהם על בסיס סגמנטים של לקוח בודד (Segment-of-1), שבו אפשר לשלוח מידע, למשל פרסומת, שונה וייחודי לכל לקוח ולקוח. כלומר, כל לקוח הוא לקוח ייחודי, ואפשר להתאים לו פרסומות המתאימות לו.

מרכיבי הביג דאטה

כדי להבין טוב יותר מה עומד מאחורי המושג הכללי הזה שנקרא ביג דאטה, נסקור את שלושת מרכיביו העיקריים, המכונים 'שלושת ה־V־ים', שאפשר לראותם כשלושת הממדים המאפיינים את מרחב הביג דאטה: Volume – נפח; Variety – מגוון; Velocity – מהירות

נפח: ביג דאטה הוא קודם כל 'ביג'. גדול. נתונים רבים. כיום יש יותר ממיליארד משתמשים ורבע אקטיביים בפייסבוק, בכל חודש, ב־70 מדינות שונות ברחבי תבל. יותר ממיליארד אנשים שונים צופים בשש מיליארד שעות של סרטוני יוטיוב בכל חודש ומעלים בכל דקה 100 שעות של סרטונים חדשים. בכל יום שישה מיליארד חיפושים (70 אלף חיפושים בשנייה) נערכים בגוגל ו־800 מיליון ציוצים חדשים נכתבים בטוויטר (9,000 בשנייה). קצב גדילת המידע באינטרנט גדֵל באופן מעריכי (אקספוננציאלי) ולפי פרסום של IBM כ-90 אחוז מהמידע בעולם נוצר בשנתיים האחרונות.

למספרים הללו יש השלכות טכניות ברורות: אין באפשרותן של הטכנולוגיות הישנות והסטנדרטיות לאחסן, לעבד ולהגיש כל כך הרבה מידע ונתונים, חלקם בזמן אמת, לכל כך הרבה משתמשים. הראשונים להבין זאת היו לארי פייג' וסרגיי ברין, מייסדי גוגל, אשר עוד טרם ניסוח האלגוריתם פייג'־רנק (Page Rank) המפורסם שלהם, שינו לעד את תפישת עיבוד המידע בעולם המחשוב. מעיבוד מרוכז בשרתים חזקים מאוד ויקרים (גישת Scale Up) הם עברו לעיבוד מבוזר ומקבילי בהרבה מאוד שרתים זולים, המקובצים יחדיו באשכולות, Clusters (גישת Scale Out). כדי לתמוך בגישה מבוזרת זו המציאו אנשי גוגל את מערכת הפעלה ייחודית, התומכת בעיבוד המבוזר של המידע באופן טבעי, GFS (ראשי תיבות: Google File System), ואילו אנשי חברת יאהו דאג קאטינג ומייק קאפארלה כתבו כחמש שנים לאחר מכן תוכנת ביג דאטה שלמה בשם האדופּ, Hadoop (על שם בובת הפיל של ילדו הקטן של קאטינג), הכוללת מערכת הפעלה דומה בשם HDFS (ראשי תיבות: Hadoop Distributed File System). את התוכנה הזו הם כתבו תחת חסותו של פרויקט הקוד הפתוח הגדול ביותר כיום, Apache, שמעניק את התשתית לרוב החברות בעולם המפעילות טכנולוגיות ביג דאטה. יש הטוענים כי הביג דאטה הפך להיות הטרנד הטכנולוגי החזק ביותר, בגלל העלות הנמוכה פי חמישה של תשתית Hadoop לעומת שרת אורקל שהוא יקר וזהה בביצועיו.

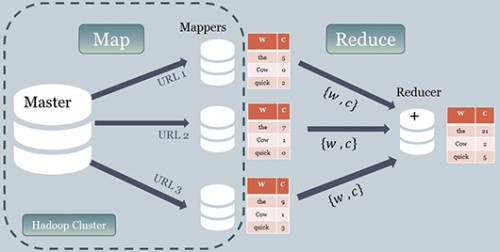

אנשי גוגל הביאו לעולם דהמצאה נוספת – Map Reduce. זוהי שיטת חישוב חדשה המאפשרת עיבוד של כמויות נתונים אדירות, כמו שרק גוגל הצליחו לעבד בתחילת שנות האלפיים. ה־Map Reduce משתמשת בתשתית המבוזרת ומחלקת את משימת החישוב לשני שלבים. שלב המיפוי, Map, שבו מפוצלת משימת החישוב וממופה לשרתים רבים, שכל אחד מהם מבצע חלק מהעבודה במקביל לשרתים האחרים. בשלב השני, ב־Reduce, התוצאות החלקיות של שרתי ה־Map נאספות לתוצאה סופית אחת.

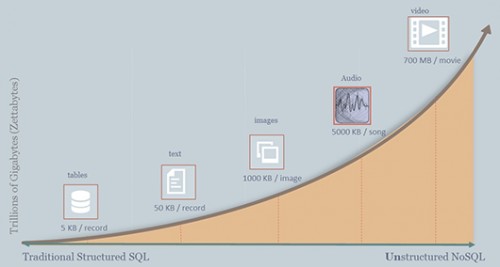

מגוון: קצב הגידול המואץ של כמות המשתמשים ברשת הביא לקצב גידול מואץ אף יותר בנפח הנתונים. אם פעם הנתונים ששמרו ארגונים על העסק שלהם ועל הלקוחות היו אחידים, מובְנים (Structured) ומסודרים בתוך טבלאות בבסיסי נתונים מסוג SQL, היום לנתונים אופי שונה, מגוּון הרבה יותר ובלתי מובנה (Unstructured), ובהם אפשר למצוא טקסט חופשי (תוכן דפי אינטרנט, ציוצים ופוסטים), תמונות (פייסבוק, פליקר, פיקאסה), קובצי קול (שאזאם) ווידיאו (יוטיוב), שנשמרים בבסיסי נתונים מסוג חדש, NoSQL Databases. איור 1 ממחיש את המַעבר מהמידע המובְנה (Structured Data) למידע הבלתי מובנה (Unstructured Data). האיור ממחיש את הגידול האקספוננציאלי בנפחים של סוגי מידע שונים.

איור: גלעד ברקן

אם בבסיסי הנתונים הטבלאיים המסורתיים מסוג SQL דרושה הגדרת סכמה מסודרת של סוג הנתונים שרוצים לשמור, אזי שלבסיסי הנתונים הלא מובְנים מסוג NoSQL לא ממש אכפת איזה סוג מידע נשמר בתוכם. לדוגמה, אם ברשותנו יישום השומר תוכן דפי אינטרנט, נשתמש בבסיס נתונים מסוג NoSQL, שהמפתח אליו יהיה כתובת האתר והערך יהיה תוכן הדף, בין אם זה טקסט, אודיו או וידיאו.

מהירות: בעולם התזזיתי שבו אנו חיים כיום, הורגלנו להמתין לדף אינטרנט שביקשנו לא יותר משנייה. והנה, במשך שברירי שנייה קורים נסים ונפלאות. גוגל יחזירו תשובה לחיפוש שלכם; אאוטבריין הישראלית תספק לכם המלצות לכתבות שעשויות לעניין אתכם ו־DG ו־MyThings הישראליות יסחרו בפרסומות בגוף דף האינטרנט שאתם קוראים לאחר שחצה את האוקיינוס. בכל הדוגמאות הללו אלגוריתמים מתמטיים מייצרים באופן אוטומטי תוכן דינמי לדף שביקשתם, במקסימום רבע שנייה!

כדי להצליח להריץ אלגוריתמים עבור עשרות אלפי בקשות בשנייה נוצרו בסיסי נתונים מסוג חדש. בניגוד לבסיסי הנתונים הרגילים (גם SQL וגם NoSQL), המבוססים בדיסקים קשיחים, ולכן אטיים יחסית, בסיסי הנתונים החדשים, ה־In Memory DBs, מאחסנים את כל הנתונים שלהם בזיכרון המהיר של המחשב (ב־RAM או בזיכרון המטמון, Cache), ולכן שליפת הנתונים מהם מהירה מאוד. הבעיה היחידה בבסיסי הנתונים הללו היא שהם יקרים מאוד. אופטימיזציית מהירות נוספת היא הרצת האלגוריתמים מתוך מרחב הזיכרון של בסיסי הנתונים. בצורה הזו לא מתבזבז זמן במעבר הנתונים בין בסיסי הנתונים והאלגוריתמים עצמם שעושים בהם שימוש.

פרסום בזמן אמת

כיום, הפרסומות בדפי האינטרנט שאנו צופים בהם מותאמות לנו אישית, ושני אנשים שונים הצופים באותו דף אינטרנט, באותה הכתובת, יצפו בפרסומות שונות שיוצגו להם בדף. מה מתרחש מאחורי הקלעים מרגע לחיצת הכפתור על לינק דף האינטרנט עד הרגע שהדף מוצג לנו? ברגע בקשת התוכן לדף נשלחת במקביל בקשה לבורסת פרסומות, שאליה נרשמים מפרסמים. אל הבקשה לפרסומת מצורפים פרמטרים רבים, בהם מי מבקש את הפרסומת (האם זה ה"ניו יורק טיימס" או בלוג שולי), מיקום הפרסומת בדף (בכותרת או בתחתית הדף), גודל הפרסומת, מידע על המשתמש שמבקש את הדף ועוד. בורסת הפרסומות (גוגל היא הבורסה הגדולה והפופולרית ביותר כיום) שולחת את הנתונים הללו לכל המפרסמים הרשומים. המפרסמים מריצים אלגוריתמים שמחשבים את כל הנתונים הנ"ל ומציעים סכום (Bid) עבור פרסומת זו. המרבה במחיר זוכה בפרסומת. גולת הכותרת של כל התהליך היא שמשך הזמן הכולל של כל השלבים הללו הוא… עשירית שנייה!

חישוב מקבילי ומבוזר

בבסיס כל מנוע חיפוש עומד מילון סטטיסטי של מילים בדפי אינטרנט המודד את מספר המופעים של כל מילה. למשל המילה "The" היא המילה הנפוצה ביותר בשפה האנגלית והיא מופיעה בכחמישה אחוזים מכלל מופעי כל המילים. מילון סטטיסטי כזה הוא רב חשיבות למנוע חיפוש, והוא משמש לשליפת דפי האינטרנט הרלוונטיים ביותר בהתאם למילות החיפוש.

בניית מילון כזה מתוך כמה מיליארדים של דפים יכולה להיות משימה כמעט אינסופית, אם היא לא תיעשה באופן מבוזר ומקבילי. כפי שתיארנו, Map-Reduce היא דוגמה לשיטת חישוב מבוזרת ומקבילית, העושה שימוש בתשתית המבוזרת ומחלקת את משימת החישוב לשני שלבים, המתוארים בתרשים 4. בשלב הראשון, שלב המיפוי, Map, מפוצלת משימת החישוב וממופה להרבה שרתים (Mappers), שכל אחד מבצע חלק מהעבודה במקביל לשרתים האחרים. בדוגמה שלנו כל שרת מקבל כתובת של דף אינטרנט אחד וסופר כמה פעמים הופיעה כל מילה בדף שלו. למשל בשרת 1, המילים The ,Cow ,Quick מופיעות חמש, אפס ושתי פעמים בהתאמה. בשלב השני, ה־Reduce, התוצאות החלקיות של כל שרתי ה־Map נלקחות ומקובצות יחדיו לתוצאה סופית אחת. המילים The, Cow, Quick מופיעות בשלושת הדפים 21, 2 ו־5 פעמים בהתאמה.

המשרה הנחשקת ביותר

כל תשתית הביג דאטה שציינו אינה שווה מאום אם לא יופק ערך ממשי ואופרטיבי מתוך הנתונים הללו. העתיד שייך לחברות ולאנשים שיהפכו את הנתונים הללו למוצרים וליתרון עסקי אמיתי על פני המתחרים. דוגמה טובה לכך היא חברת אונאבו הישראלית, שנרכשה בשנה האחרונה על ידי פייסבוק תמורת 150 מיליון דולר. אונאבו פיתחה מוצר לניטור אפליקציות בסמארטפונים. בשלב מסוים הבינו הסטארטאפיסטים מאונאבו שהערך האמיתי שיש להם ביד הוא הסטטיסטיקות שהחלו לאסוף על כל האפליקציות הללו במיליוני הסמארטפונים שניטרו. פייסבוק מצאה ערך רב ביכולת זו ורכשה, כאמור, את אונאבו. אם כך, הכוכבים החדשים של התעשייה הם מדעני הנתונים, ה־Data Scientists .

ה־Harvard Business Review הגדיר את מדעני הנתונים כבעלי המשרה הסקסית ביותר במאה ה־21. ה־Wall Street Journal טען שב־2013 הם הרוויחו שכר שנתי של עד 300 אלף דולר. מי הם מדעני הנתונים הללו? כיצד הפך מקצוע, שעד לפני שנתיים לא היה קיים כלל, לכה נחשק?

מקצוע מדען הנתונים הוא הכלאה של כמה בעלי מקצוע. ראשית, הוא בעל השכלה אקדמית מתקדמת במקצועות כמו מתמטיקה, סטטיסטיקה או מדעי המחשב. שנית, הוא מכיר תוכנות ושפות תכנות או לפחות יודע לכתוב קוד בשפות עיבוד נתונים ייעודיות כגון R. ולבסוף, הוא צריך להיות מומחה בתחום העסקי שאליו הוא שייך. במציאות, קשה למצוא אדם אחד שיענה על כל הדרישות הללו, ולכן בונים צוותים של מדעני נתונים.

מדעני הנתונים, או כּוֹרי המידע (Data Miners), הם כורי הזהב של העולם המודרני. הם אלו שימצאו את המחט בערמת השחת. ערמת השחת, המשולה לשפע הנתונים, היא היא הביג דאטה, וכיום אכן מדובר על ערמה גדולה מאוד. קשה למצוא מחט בערמת שחת כה גדולה או במילים מדעיות, קשה להפריד את האות מהרעש, את ההקשרים ואת התובנות האמיתיות החבויים בתוך ערמת הנתונים. אך מנגד, כיוון שסטטיסטיקה היא הדלק של כריית המידע, הרבה נתונים משמעם סטטיסטיקה אמינה ומדויקת יותר, ולכן תובנות אמינות ומדויקות יותר.

את שלבי אנליזת הנתונים הכרוכים בפיתוח מוצר אפשר להבין על ידי הדוגמה הבאה: נניח שחברת פיצה מסוימת שכרה את שירותינו כמדעני נתונים, כדי לבנות קמפיין טלפוני ללקוחות פוטנציאליים שבו יעניקו המוקדנים קופון ללקוח לרכישת פיצה בהנחה. מכיוון שעלויות קמפיין טלפוני הן גבוהות ביותר, הרעיון המרכזי העומד בבסיס הקמפיין הוא להתקשר ללקוחות המתאימים ביותר. במילים אחרות, עלינו לבנות מודל שיחזה מי הם הלקוחות הרלוונטיים ביותר, שעשויים להשתמש בקופון הטלפוני שיקבלו ואכן ירכשו פיצות. השלב הראשון בבניית הקמפיין מתחיל בנתונים עצמם. ראשית עלינו להגדיר מהם הנתונים הרלוונטיים שיעזרו לנו לחזות בהצלחה את הלקוחות הפוטנציאליים. כתובת הלקוח, למשל, עשויה להעיד על יוקרת אזור מגוריו; כך גם גיל הלקוח – האם אלו צעירים הניזונים מאוכל מהיר או מבוגרים שניזונים מאוכל מבושל; היסטוריית הזמנות של הלקוחות; בדיקה האם הלקוחות הפוטנציאליים הגיבו כבר לקמפיין בעבר? לאחר הגדרת הנתונים שחשוב לנו לקבל, ננסה להשיג אותם מתוך מערכות המחשוב של הפיצרייה (כבר נוכחנו שעדיף שיהיו בידינו כמה שיותר נתונים); לבסוף, עלינו להבין את הנתונים שקיבלנו, דהיינו – להבין את כל הטבלאות ושמות הקוד של כל השדות בתוכָן.

השלב הבא הוא שלב הכנת הנתונים, הכולל את טיוב הנתונים, סינונם ואיחוד כל הפורמטים לקנה מידה אחיד ויחיד. למשל, הפרטים על המגורים ועל גיל הלקוחות לקוּח מתוך טבלאות SQL, בעוד שהיסטוריית ההזמנות לקוחה מתוך קובצי אקסל. שני שלבים ראשונים אלו צורכים בדרך כלל 80 אחוז ממשך העבודה. כאן זה אולי המקום לציין שעל אף הזוהר והשכר הגבוה שמקבל מדען הנתונים בעל ההשכלה האקדמית המתקדמת, 80 אחוז מהזמן הוא עושה עבודה שחורה. אך ייתכן שזו מנת חלקם של כל המדענים. לא בכדי מכוּנים מדעני הנתונים גם כּוֹרי נתונים (Data Miners). שלב המודלים והאלגוריתמים הזוהר ובעל ההילה הנוצצת, שמאחוריה עומדים הכישורים המתמטיים והאקדמיים של מדען הנתונים, צורכים לכל היותר עשרה אחוז מכלל התהליך.

בשלב הבא, יש לבנות את המודל המתמטי שיאסוף את כל הנתונים שהוזנו, ויחזה מי הם הלקוחות הפוטנציאליים. כדי לבנות את המודל הסטטיסטי הסופי אנו בוחרים ומעריכים אלגוריתמים שונים המתאימים לפתירת הבעיה ולבסוף מהנדסים את המודל הסופי. כשהמודל המתמטי לחיזוי הלקוחות הפוטנציאליים לקמפיין בידינו, אנו יוצאים מ"המעבדה" ומטמיעים אותו בתוך המוצר הסופי ב"שטח". כשהמוצר עובד ופועל בזמן אמת ואנשי הטלמרקטינג מתקשרים ללקוחות הפוטנציאליים, אנו מפקחים על ביצועי המודל שלנו ורואים אם הוא עומד בדרישות המערכת שקבענו מראש, ואם הוא מתאים למושגים שלהם המשמעות העסקית הרלוונטית לבעייתנו. לרוב נבחן את ביצועי המודל לפי סט מדדים (KPIs – Key Performance Indicators) או לפי ה־ ROI(ראשי תיבות: Return on Investment) של המוצר שלנו. בדוגמה שלנו, נמדוד את מידת הצלחת המודל שלנו לפי סך ההכנסות מאנשים שקיבלו קופון והשתמשו בו.

כדי להשתפר, לדייק יותר וללמוד ללא הרף את השינויים בסביבת המוצר שלנו, אנו שבים ומתחילים את כל התהליך מחדש, כך שמדובר בתהליך מחזורי שמשנה פנים כל הזמן, משתפר ומתאים עצמו לשינויים הסביבתיים שבו חי המוצר בפועל.

לסיכום, ביג דאטה, מהמונחים הלוהטים ביותר כיום בעולם הטכנולוגיה, אינו בועה כלל וכלל, אלא טכנולוגיה מבוססת, שכל שנה מתווספים לארסנל שלה הרבה מאוד שירותים וטכנולוגיות חדשים, שברובם המכריע ניתנים בחינם על בסיס קוד פתוח. טכנולוגיות אלו מניידות את שיטפון הנתונים דרך המודלים והאלגוריתמים שרוקחים מדעני הנתונים ליישומים המניבים ערך רב.

Big Data – Big Value.